- 科技報導

- 資訊生活

文章專區

2023-10-15難辨虛偽和真實,Deepfake技術造成的AI倫理與法規挑戰

502 期

Author 作者

許志仲/成功大學統計學系助理教授

在近年來人工智慧(artificial intelligence, AI)技術發展中最具爭議和吸引力的技術,恐怕莫過於Deepfake了。近幾年,Deepfake利用深度學習技術(deep learning)模仿真人的語音和臉部表情,可以製作出相當擬真的假影視訊和聲音。這項技術的崛起,不僅引發了科技界的關注,也引起了公眾的廣泛討論。

Deepfake源自於深度學習和偽造(fake)兩個詞的組合。早期的技術還不夠成熟,生成的影像和聲音往往有許多不自然的地方而容易被識別。但隨著研究者不斷努力以及技術的進步,這些問題逐漸被克服,現今的Deepfake已經能夠製作出非常逼真的偽造內容,即使是專家也難以分辨影音中的真偽。

對於電影製作人和電影特效的公司來說,Deepfake是一個極具吸引力的技術,可以節省大量的成本和時間。例如當一位演員因為某些原因無法出演某部分場景時,可以使用Deepfake技術來替代真實的演員。然而,凡事都是一體兩面,這項技術也帶來了很多潛在的問題。任何人都可以輕易地製作偽造的影視訊和聲音,這不僅威脅到個人的隱私和名聲,也可能影響到社會和國家的安全。因此,如何正確使用和監管這項技術,成為了現代社會的一項重要議題。

Deepfake的影響與危害

Deepfake技術在社會上引起的震撼不僅來自於逼真的生成能力。事實上,Deepfake背後隱含的社會和道德問題遠超過技術成就。偽造的影視訊和聲音可能會被用於詐騙、誹謗、政治操作等不正當目的。當我們深入探討各種可能危害時,會發現到潛在的威脅遠遠超出一開始的想像。

1.隱私與名譽的傷害:Deepfake技術可以仿造任何人臉,這意味著無辜的人——特別是公開影像眾多的知名人士——可能會被置於不真實的場景中,進而造成名譽上的傷害。例如公眾人物可能被偽造為參與某些不道德或非法的行為,而普通人也可能成為詐騙的目標。

2.政治操作和偽造新聞:在政治領域,Deepfake技術有可能被用來製造假新聞或偽造政治人物的言論和行為。這不僅可能誤導選民,還可能對選舉結果產生重大影響。當真實的事實被扭曲或隱藏,民眾可能會受到影響而誤判。

3.經濟和商業風險:在商業領域,偽造的影視訊或聲音可能被用於詐騙手法。例如一段偽造的CEO發言或內部會議錄音可能導致公司的股價大幅波動。

4.情緒心理影響層面:對於那些被Deepfake偽造的目標,除了隱私和名譽受損外,當事人還可能遭受深重的情感和心理傷害。知道自己的面貌和聲音被濫用,可能會導致焦慮、恐懼和自卑感。

5.社會間不信任感升高:隨著Deepfake技術的普及,人們可能對所有影視訊和聲音內容產生懷疑,產生普遍不信任和懷疑的氣氛。當真實和虛擬之間的界限變得模糊時,社會的基本信任結構可能會遭破壞。

簡而言之,我們需要密切關注Deepfake技術的發展, 並採取適當的措施來防範此技術對社會的潛在威脅。

Deepfake如何影響AI的倫理與法規

面對Deepfake帶來的威脅,許多人開始研究相關的法規和政策,以限制技術的不正當使用。AI倫理做為近期熱門的討論話題,Deepfake的威脅更在相關倫理規範制定過程中占有重要的一席之地。首先,AI倫理的核心價值主要牽涉到技術如何影響個人和社會的權利,以及透明度等問題。而Deepfake技術則為這些問題帶來了新的挑戰,以下舉幾個例子來做說明:

1.隱私權的重新定義:傳統上,我們認為隱私是一個人的基本權利,但在Deepfake時代,此概念受到了挑戰。當任何影片都可以輕易被模仿、偽造成另一個人的面貌和聲音時,隱私的界限將變得更加模糊。這也促使我們重新考慮隱私的定義和保護機制。大家不禁開始思考,上傳照片到網路上時是否仍要放真實照片?

2.透明度和真實性的價值:在假新聞和偽造內容充斥的時代,資訊的透明度和真實性變得愈來愈重要。人們開始質疑他們所看到和聽到的一切,這促使技術公司和政府機構尋找更好的方法來確保訊息的真實性。特別是如何保持資訊流的透明公開,以獲得公眾的信賴。

3.公正與偏見:雖然Deepfake技術本身不會直接造成偏見,但它顯示了AI系統可能如何遭濫用而加劇社會本身的不平等和偏見。例如偽造的影視訊可能會被用於誹謗特定的族群或社區,在社群媒體時代可能影響甚鉅。

4.技術社群的道德責任:隨著Deepfake技術的普及,開發和布署這些系統的公司和個人將面臨著更大的道德責任,必須確保這項技術不被用於有害或不道德的目的。然而一體兩面的是,學術與技術發展若遭遇過多規範,便有可能會限制了後續的技術發展。

5.法規需迅速適應:傳統的法律和規定往往難以跟上技術的迅速發展。面對Deepfake這樣的新技術,政府和立法機構需要更加靈活和迅速地制定和修訂相應的法律,以保護因為Deepfake而受到影響的人們。

6.公眾教育和意識:除了法律和規定,相關的公眾教育和意識也是避免Deepfake造成危害的關鍵。人們需要了解Deepfake技術的潛在威脅,並學會如何識別和應對偽造的內容。舉例來說,民眾應學著以先思考再轉發的概念來看待資訊,並反覆審視自己所看到的多媒體資訊。

Deepfake技術不僅改變了我們對真實和虛擬世界的看法,也促使我們重新考慮AI技術的倫理和法律問題。在這個快速變化的時代,我們需要不斷地反思和調整我們的觀念和策略,以確保技術的健康發展和社會的安全。

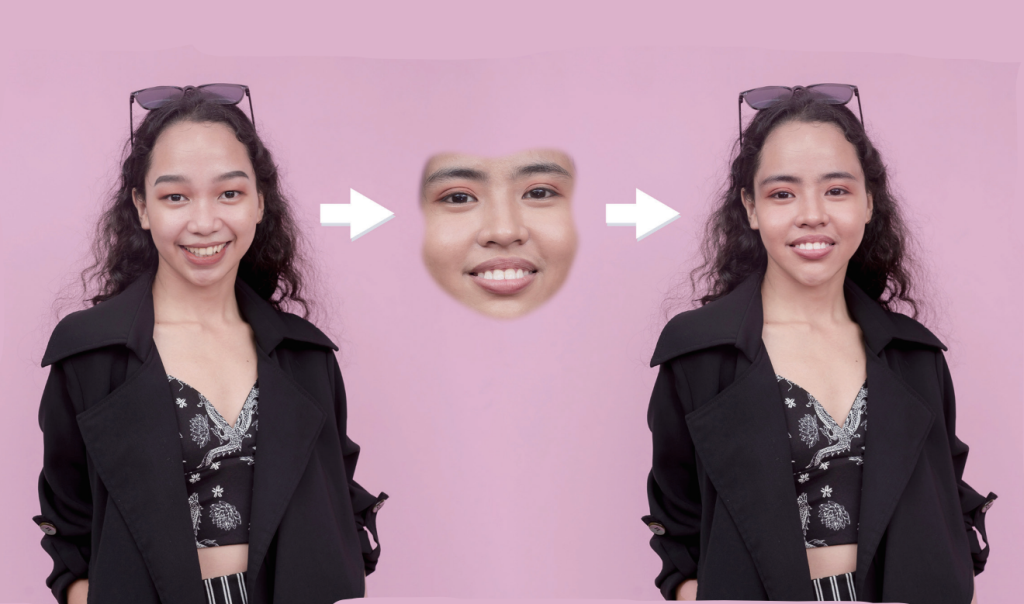

一張展示 Deepfake 技術效果的圖片,左邊是真實的人物,右邊是由 Deepfake 生成的影像。(Adobe Stock)

現行策略:被動偵測與法律防治

目前,對於Deepfake的應對策略主要分為兩大類:被動偵測和法律防治。被動偵測主要是藉由技術手段,例如以影像分析和語音辨識來識別和過濾偽造的內容。而法律防治則是藉由立法,禁止或限制Deepfake技術的不正當使用。

面對Deepfake這種具有高度逼真性的技術,社會各界已經開始採取措施以減少它的潛在威脅。這些策略大致可以分為技術、法律,以及社會教育三個方向。

1.技術策略:被動偵測

•學習可靠的偽造特徵來辨識:許多研究者已經發現Deepfake影視訊中可能存在的微小異常。這些異常可能是肉眼難以察覺的,但透過分析技術例如微表情分析、眼球運動,甚至是嘴形變化,仍可以識別出偽造的內容。

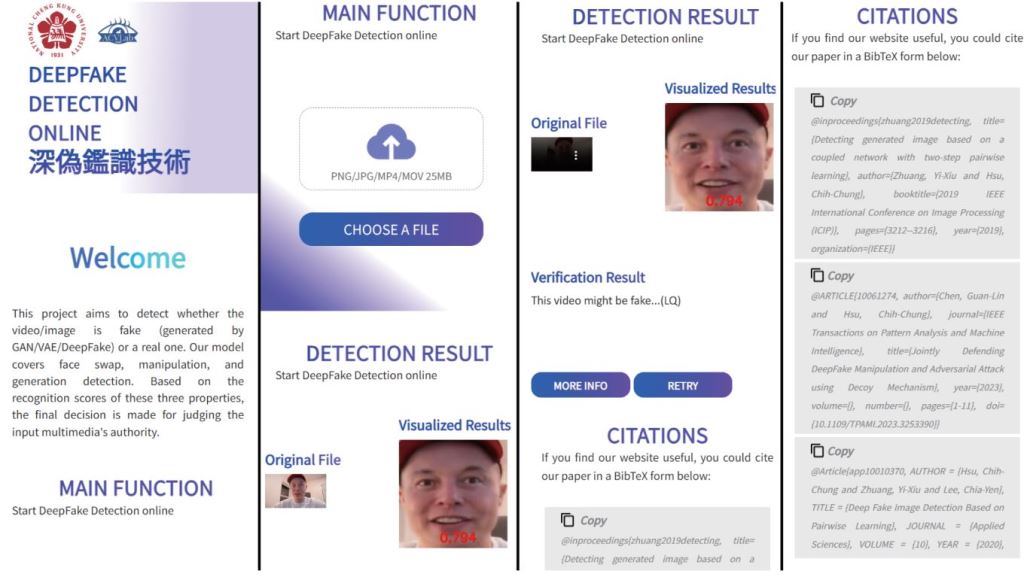

•AI對抗AI:考慮到Deepfake是由AI技術生成,另一個可靠的手法是訓練專門的AI模型來識別偽造的內容。這些技術的發展通常到最後會成為AI的攻防戰,Deepfake一方面發展更可靠的AI生成模型,而另一方面則不斷加強這些針對Deepfake影片的偵測能力。如何因應品質愈來愈擬真的生成影視訊,仍是近年來許多研究者的目標。舉例來說,我們兩年前也開發了一套Deepfake偵測的系統並持續更新中,現階段它可辨識出四種不同的深度偽造。然而技術日新月異,因此我們的防禦技術也必須持續進步,才能持續穩定偵測更先進的Deepfake。

Deepfake 的被動偵測技術示意,可直接上傳影片與照片並進行分析系統將會給出不同 Deepfake 偽造方法的可能性與評分。(作者提供)

2.法律策略:法律防治

•新的法條:許多國家和地區已開始審查他們的現行法規,以確定是否需要制定新的規範來禁止或限制Deepfake的使用。這些新法規通常會針對製作和散播偽造內容的行為,尤其是當目的是詐騙或試圖影響選舉。

•擴大現有法規的範疇:除了制定新法律,某些地方也正在考慮如何將現有的隱私、名譽和詐欺法擴大到涵蓋Deepfake相關的行為。

3.社會教育的角色

•內容平臺的審查:許多社交媒體和影視訊分享平臺近期或多或少開始採用AI工具來自動識別和過濾偽造的內容。雖然這些工具可能還不完美,但它們至少提供了一個第一道防線。

•公眾教育:許多企業和非營利組織正在開展公眾教育活動,以提高人們對Deepfake威脅的認識。藉由教育和培訓,我們可以教育公眾如何識別和應對偽造的內容。

未來的展望

儘管現在已有很多應對Deepfake威脅的策略和技術,但隨著技術的進一步發展,我們還需面對更多的挑戰。未來,也需要更加完善的技術和策略,以及更嚴謹的AI倫理和法規,以確保技術的健康發展和社會的安全。總結來說,身為研究者的角色,筆者認為未來雖然充滿了挑戰,但同時也有許多機會。只有仰賴於產學研乃至於政府各方不斷的通力合作,才能確保技術的益處可以遠大於潛在的風險。