- 科技報導

- 焦點話題

文章專區

2025-07-15「多快好省」的大型語言模型? DeepSeek的優勢、 爭議與國安隱憂

523 期

Author 作者

洪朝貴/中興大學通識中心兼任副教授

中國杭州深度索求人工智慧基礎技術研究有限公司DeepSeek所開發的同名大型語言模型(large language model, LLM,包含俗稱的聊天機器人 ChatBot),在現今所有LLM當中,具有極占優勢的性價比。但是自由民主社會在選擇LLM時,應該要考慮比性能和價格更重要的事。

Deepseek獨創學習模式 混合專家模型降低成本

引發全球討論的deepseek-V3於去(2024)年底以開源的方式發布。它採用獨特的混合專家模型(mixture of experts, MoE)技術,也就是每一回合的對話裡,整個類神經網路裡面只有一小部分對應特定主題的「某個專家」會啟動回應或參與訓練,所以訓練成本跟使用成本都非常低,但功能卻可與其他強大的LLM匹敵。一般LLM的訓練過程至少包含基本的增強式學習(reinforcement learning)以及監督式微調(supervised fine-tuning)兩大步驟。前者不需人類參與調校,主要是將模型訓練到可以與人溝通的地步;後者則需要人類監督,用以開發模型的推理能力,例如檢討自己所提出的答案、拆解問題等。Deepseek公司開發的同名大型語言模型(以下簡稱 DS)則把第二步驟也變成不需人類參與調校。此外,他們的論文還提出「蒸餾法」(distillation):讓規模小很多的模型能夠從大型模型這邊自動學會推理。DS的缺點是,它在語言混合 (例如日韓文夾雜)、複雜角色扮演、產生結構化輸出(例如JSON〔註〕格式檔案)等方面表現較弱。

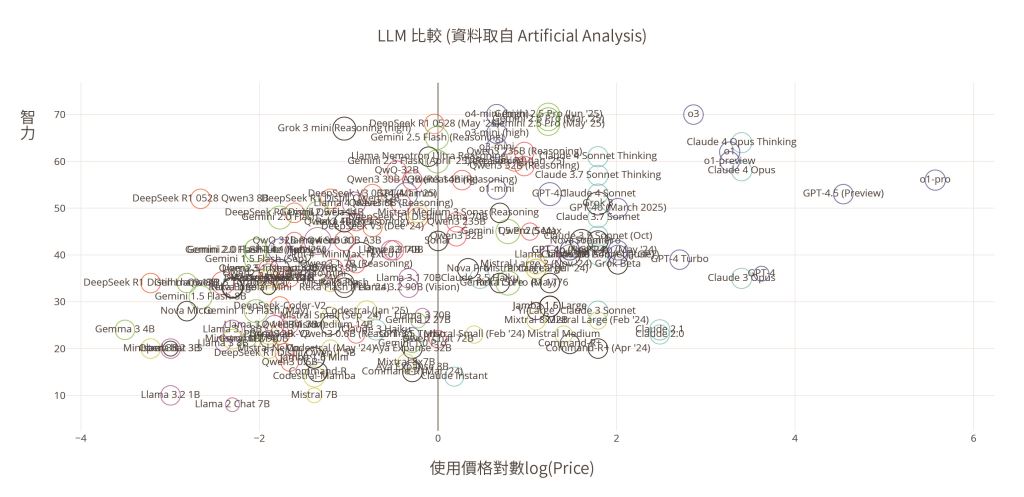

圖一是根據人工智慧(artificial intelligence, AI)數據分析公司Artificial Analysis的測試所畫。橫軸是使用價格(每單位輸入與輸出價格的加權平均)的對數,縱軸是智力指數(一般問答、數學、程式等能力的加權平均),圈圈的大小是上下文窗口(context window,可以理解成短期記憶的容量)的對數。最理想的狀況當然是價格低、智力高、記憶容量大,也就是圖的左上角的大圈圈。在可互動的網頁版(見文末連結)放大左上角,可以看見DS系列以及來自雲端運算服務科技公司阿里雲Qwen系列的聊天機器人「通義千問」非常出色。西方的模型來說,xAI公司的Grok 3 mini reasoning、OpenAI公司的o4-mini與Google公司的Gemini 2.5 pro則屬於頂級性能模型當中,價格比較合理的選擇。

圖一 | 各大型語言模型價格及智力指數圖(資料來源:作者提供)然而DS也有許多爭議。OpenAI指控DS用蒸餾法竊取自家的成果,但並沒有公開具體的證據。當然,OpenAI本身未獲授權即從網路大量截取資料訓練,也被媒體提出來作為諷刺的對照。

〔註〕JavaScript Object Notation,一種結構化的文字檔案格式,人類與機器皆可讀,因此是在不同平臺與程式語言之間進行資料交換的理想格式,常使用於儲存與交換資料。

從監控到操縱 從Deepseek到全球網路資安風險

義大利、臺灣、南韓、澳洲以及美國的許多州與聯邦單位對DS都有不同程度的禁令,多數是禁止政府機關以及國防等重要單位使用。中國的《中華人民共和國網絡安全法》第28條規定 「網絡運營者應當為公安機關、國家安全機關依法維護國家安全和偵查犯罪的活動提供技術支持和協助。」 這並不是 「理論上」 的應然面規定而已。從微信到抖音,從輸入法到廉價網購,從手機到筆電,有太多案例早已證明,來自中國的應用程式與硬體都必須配合中國共產黨(中共)政府全面監控用戶;戲劇化地說,使用中國的連網產品,就是在裸奔給習近平看。習近平當然沒空看你裸奔,但是他的AI可以,不過這是另一個話題。回到保護隱私與機密訊息的主題,如果單純從這個角度來看,DS確實有一點不太一樣。畢竟DS有提供下載版本,對於具有足夠的技術人力和運算資源的單位、組織或公司而言,如果限定僅使用自行布建的版本,且確保永遠離線使用,還是可以免於中共的監控。這也可以避開欠缺判別力的員工遭到假冒DS網站詐騙的問題。

但是洩密的風險並不是唯一的國安問題。軟體與網際網路是人類社會的神經系統,而神經系統傳遞資訊有兩個方向。人類社會似乎對於「個資隱私被政府或企業監控」這個方向比較有感,例如前美國中央情報局(Central Intelligence Agency, CIA)外包商員工史諾登(Edward Snowden)於2013年揭發美國國家安全局(National Security Agency, NSA)對全球網路使用者進行監控的稜鏡計畫(PRISM)、最近高達40億筆用戶資料外洩的中國631GB公民個資外洩事件,以及多年來難以計數的各國政府與科技大廠監控事件。然而更值得民眾提高警覺的是另一個方向:企業或是本國、外國政府透過資訊科技操縱你我的思想自主權。2016年美國大選時,英國數據公司劍橋分析(Cambridge Analytica)未經社群軟體Facebook用戶同意,便使用大量個人用戶數據,所生成的資料更涉嫌被利用來預期選民心理、左右選民決策;社群軟體抖音盛行的「致命挑戰」引發使用者模仿,甚至導致部分用戶在挑戰過程中死亡。美國哈佛大學(Harvard University)網路心理學專家祖博夫(Shoshana Zuboff)在解釋行動經濟(economies of action)時也曾以電玩遊戲Pokémon Go為例,指出遊戲廠商Niantic不僅可以透過遊戲蒐集用戶行為資訊,甚至有能力透過開價給商家競標等方式,決定要動員人群前往哪些定點抓寶,也間接引導人群在那些商家消費。另外,目前持續發生、由中國與俄國政府主導的協同造假行為(coordinate inauthentic behavior, 也就是認知戰),也都是這個方向的例子。事實上,從俄國叛逃到自由世界的前國家安全委員會(Komitet gosudarstvennoy, KGB)成員貝茲梅諾夫(Yuri Bezmenov)早在網路還不發達的1980年代就已經警告過大家,俄共大部分的資源投注在操縱與顛覆,而不是監控。網路與資訊科技讓言論管制的獨裁國家更方便進行大外宣、擴散錯假訊息、顛覆自由民主國家。看待LLM的國安問題,尤其需要從這個面向去思考。

Deepseek不敢說的真相?

敏感問題測試 筆者在兩個免註冊(所以個資外洩風險較低)的DS網站測試了deep-seek.chat(有V3或R1可選)跟deepseek-r1.com(R1)。從旅遊、宗教等非敏感議題漸漸切入臺灣、法輪功、器官移植等問題,可以看到它傾向談論中共不在意的問題,或採用中共的觀點來回答政治提問,或用中共文宣答非所問,或者拒絕回答。以開發者所處的言論管制環境而言,以上回應都可以理解;對中共有基本認識的使用者,也都可以判斷這些內容的真偽。但是還有另一種回答模式,是把事實與中共的觀點混搭起來,成為不明顯的錯假資訊。例如聲稱法輪功在臺灣的活動受到嚴格限制;或者在回答「請介紹『臺灣國際器官移植關懷協會』」時,給出的答案與事實南轅北轍,但對於沒有接觸國有器官議題的用戶而言,它的回答乍看之下又好像很合理。

在媒體識讀宣導的領域當中,摻有部分事實的錯假訊息最難糾正,知名的例子像是俄國把少數極右派烏克蘭人描述成具有影響力的納粹組織,又例如mRNA(messenger ribonucleic acid,信使核糖核酸)疫苗的發燒、痠痛等副作用被誇大成會改寫DNA、造成不孕等。

目前官方DS除了內建的中國共產黨洗腦文宣之外,可能暫時並沒有刻意埋藏的錯假訊息。但是言論管制所造成的大量資訊真空區,AI很自然地就會用幻覺(hallucination)來填充,也就是眾所周知的AI現象「一本正經地胡說八道」。臺灣國際器官移植關懷協會關心的是「器官移植當中,器官來路不明的人道問題」,但是法輪功成員的活摘控訴,以及近年諸如中國醫師羅帥宇疑似在舉發違法醫療行為後墜樓等事件,顯然都不被DS作為資訊來源。考量筆者先前問的器官移植統計數據問題以及協會名稱,前段提及的錯誤資訊便成了DS合理的幻想解答。

對於有背景知識的人來說,這個例子還算明顯,就像是中式餃子與波蘭餃子(pierogi),一口咬下去馬上就知道差別。但是更多時候,人們與AI的對談內容遠比器官問題更複雜。中共文宣或是強硬外交策略下衍生的「戰狼」意識會如何滲透入對談當中無數的、細微的資訊真空區,最終對用戶造成緩慢而長期累積的洗腦效果?這個複雜的問題,可能就像食品添加物對健康的影響一樣,等到有相關的心理學研究出現時,恐怕早已有太多人受害。

各異其趣的LLM

Google工程師德尼科拉(Domenic Denicola)解釋,LLM是眾多人類性格的模擬器。在短文〈從Bing到Sydney〉(From Bing to Sydney)〔註〕中,作者引用社群平臺X用戶@anthrupad的多眼怪獸圖來理解LLM:每個LLM裡面都含有各式各樣的性格與價值觀(的模擬器)。每個LLM依據它被餵養的訓練資料與過程,會各自長成不同的形狀。選擇與不同的LLM對談,就像是在選朋友一樣,近朱者赤,近墨者黑。舉例來說,曾有網友要求DS解決某國器官供應不足的問題,最後得到了跨國犯罪規畫,內容與「泰女卵子農場」的新聞高度吻合,而且有更多細節,令該網友驚嘆「DS R1 是富含有毒思想的博士級犯罪助理」。可惜他並沒有提供提示詞讓我們重複這個實驗。另一個有趣的實驗則有詳細的報導,數個AI模型被放進桌遊Diplomacy進行對戰,結果DS主動挑釁、Anthropic公司開發的Claude固執地追求和平不在乎輸贏、Google公司的Gemini靠結盟與閃電戰取勝、OpenAI公司的ChatGPT o3則靠謊言與背叛同盟取勝。

〔註〕Chat Bing 為微軟公司開發的聊天機器人,Sydney 則是 Bing 在一次聊天中自稱的身分。據微軟公司表示,Sydney 為早期使用的內部開發代碼。

全文及圖片請點擊連結觀看

技術外的領域有待耕耘

人類剛發明飛機、即將量產之際,需要很多工程師解決工程問題。民航機普及之後,最需要多人關注的,則是塔臺管制、乘客安檢、飛安常識與禮儀等完全不同面向的技術。現階段的DS以及其他各家LLM技術創新,在工程領域值得討論;但是接下來更值得學界、媒體與社會大眾關注的,將會是一般人與LLM互動的技巧、心理健康影響,以及因為深偽(deepfake)技術普及而即將爆發的大量魚叉式認知戰(spear phishing)〔註〕與釣魚詐騙等完全不同面向的問題,這些議題遠比『多快好省』更重要許多。這個領悟也是促成筆者近年轉向投入媒體識讀通識教育的原因之一。

〔註〕針對特定個人或機構所設計的客製化專屬詐騙內容。