- 封面故事

- 2025年

- 666期 - 與AI共生(6月號)

文章專區

2025-06-01創造雙贏局面 當AI 與臨床心理師相遇

666 期

Author 作者

李昆樺 | 國家考試及格臨床心理師,畢業於成功大學健康照護科學研究所博士班,主要研究主題為成癮行為之心理病理與治療、思覺失調症的心理病理機制與治療,與正念應用於心理疾病的療效與改變機制。

Take Home Message

• 臨床心理師藉由測驗評估、行為觀察和訪談,提出具統整性的個案心理疾病診斷,並依診斷安排後續治療。

• AI 融入心理治療中,不僅可以提供自殺風險的預測,也能在個案等待下次與臨床心理師會談前, 提供即時的回覆。

• 自殺風險預測及心理治療聊天機器人皆存在著造成個案隱私及對話紀錄外洩的風險,且也可能鬆動心理師與個案間的信任關係,而造成個案傳遞較少或錯誤的資訊,讓心理師忽略了潛在的風險。

在診間門口,一名緊張、表情哀愁的中年男性輕輕地敲著診間的門,有氣無力地對著坐在診間的臨床心理師說:「你好,我是來找臨床心理師做評估的。」聽到個案的詢問,臨床心理師平靜地從診間的椅子站起邀請個案入座, 並自然地開口說:「你好, 請坐, 讓我們來了解你目前遇到的困擾。」

臨床心理師都在做什麼?

對於臨床心理師而言,心理衡鑑〔註1〕和心理治療是每天面對個案所需要提供的專業服務。美國心理學會(American Psychological Association)對臨床心理學專業的定義簡單來說是針對個體、伴侶、家庭或團體提供持續性且全面性的心理與行為健康照護。而臨床心理師需具備心理病理的知識與技能,像是能夠整合行為觀察、問卷資料或其他資料,以評估個體的行為、認知、情緒和人際功能,並提出適當的介入計畫;重視個人的反思〔註2〕;具有臨床工作中的相關倫理; 對不同文化背景與族群的差異抱有敏感度等。

〔註1〕指透過一組心理測驗工具和會談方式,收集與個案來談問題有關的訊息,以解釋個案目前困擾可能的成因,並提出適合的治療計畫的過程。

〔註2〕指透過觀察和內省的方式,了解自己目前的行為或感受,以及可能引發這些感受或行為的過去經驗,作為臨床心理師了解和幫助個案的依據。

臨床心理師的困擾

臨床心理師在評估個體認知、情緒、行為或人際時,除了要像漫畫角色柯南一樣具有敏銳的觀察力外,也倚重對各種量表的計分和使用,透過測驗評估、行為觀察和訪談,來鑑別或排除個案目前可能的心理疾病診斷,並提出後續的治療計畫。其中最常見的量表像是智力測驗,透過使用不同面向的智力測驗工具,先根據個案的表現加以計分,再針對個案的生活功能表現,搭配著量表的分數來鑑別出個案的智能表現。

不過當個案無法配合受測或缺乏意願時,不僅評估的難度提升,臨床心理師也需花費更多時間去找到適合協助個案的方法,導致整體臨床工作的時間拉長。而人工智慧(artificial intelligence, AI)或數位科技的加入,將有望為這些問題帶來解方。

AI 在心理治療提供的解方

預測自殺風險模型

2017年美國范登堡大學(Vanderbilt University)的學者沃爾什(Colin Walsh)、雷貝羅(Peter Ribeiro)和佛羅里達州立大學(Florida State University)的學者法蘭克林(Joseph Franklin)為了要提升對自殺企圖(suicide attempt)〔註〕的預測準確率,針對5543 份急診病歷進行分析,發現其中有58.63%,也就是3250 份病歷是以自殺企圖為主,而剩餘的1917 份則與自殺企圖無關。

〔註〕指已經具有自殺行為,但沒有造成死亡的情況;而有自殺行為,但未執行則為自殺意念。

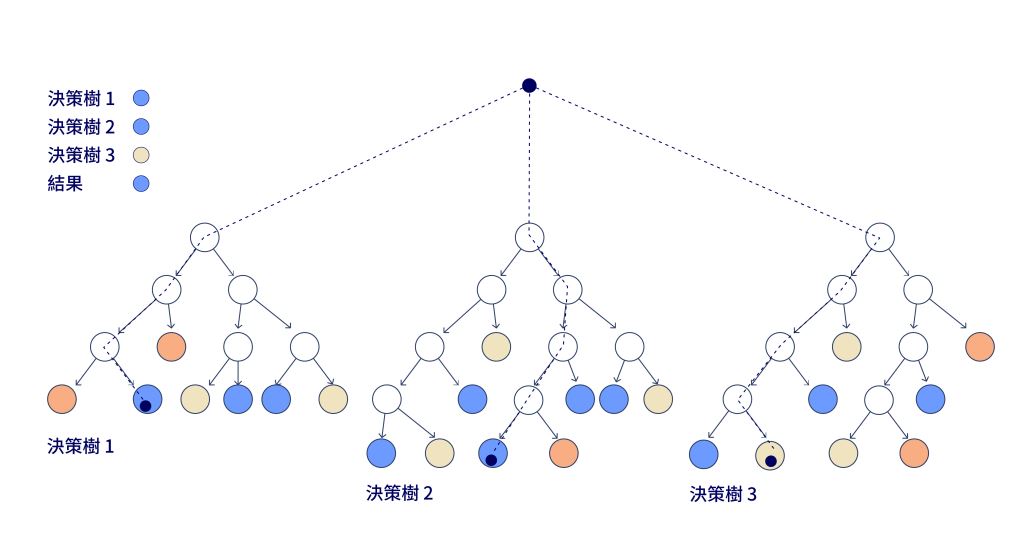

研究團隊將人口變項學資料(包括性別、年齡和種族)、疾病診斷、五年內門診或住院次數、過往自殺企圖的經驗四項指標作為預測自殺企圖的風險因素。因為研究使用的機器學習方法是決策樹(decision tree)〔註〕演算法(圖一),屬於監督式學習,所以研究者在分析資料時,需要被標籤和定義後才能進行分析,以建立四項風險因子模型,並試圖預測7 天、14 天、30 天、60 天、90 天、180 天、365 天和720 天自殺企圖的發生。結果顯示7 ~ 365 天,甚至是720 天後的自殺企圖準確率落在74 ~ 79%,而其中判定為真的有自殺企圖的準確率則是95%。

〔註〕決策樹是指當訊號輸入電腦後,可以透過原先所預設好的資料庫逐一配對,以找到最佳的配對資訊歷程。

圖一 | 決策樹演算法(Adobe Stock)

換句話說,如果我們真的將研究團隊開發的模型應用於預測臨床心理疾病患者是否有自殺企圖的風險,準確率至少是74%。而在這些被預測有可能出現自殺企圖的個案中,有95% 的比例是真的會有自殺企圖的情況。想想透過這樣的機器學習方式,只要將四項風險因子的資料輸入至預測模型,就可以幫助臨床心理師預測目前個案出現企圖自殺的可能性,而能做到提早預防或介入,讓臨床心理師和其他的臨床工作者可以有更足夠的時間來因應。

心理治療聊天機器人

普遍的心理治療過程中,個案與臨床心理師會談結束後,通常需等到一週後才會再次見面,所以在這段期間裡,當個案需要有人可以進行討論或對話時,其他的管道或專家提供協助就很重要。因此,當AI 的概念融入臨床心理師後,發展出了一個模擬心理治療師的聊天機器人(chatbot)。

在2020 年的一項整合性研究中,研究者回顧了約1200 篇將聊天機器人融入心理治療的文獻,其中治療包括了常見的認知行為治療或問題解決等,並進行逐項分析。結果顯示聊天機器人確實可以為某些個案帶來改善效果,而且接受過聊天機器人的個案認為和真正的心理治療師比較起來,聊天機器人會比較不受時間和空間的限制,隨時想找人討論就可以上線進行。但有些時候聊天機器人不太能夠提供精準或有效的回應,而且甚至會出現重複且無意義的回應。

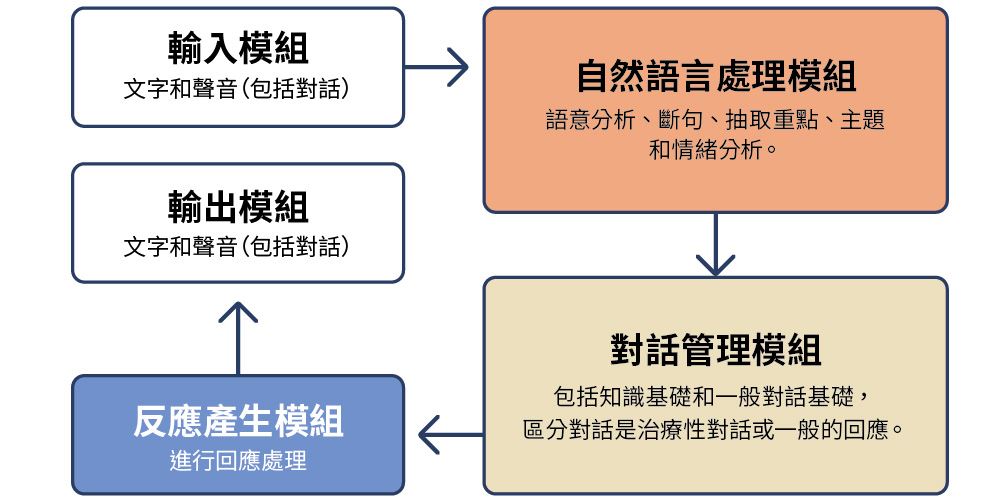

那麼聊天機器人是怎麼發展出來的呢?首先臨床心理學家會收集大量在治療時的對話,再進行內容的斷句、找出對話主題和情緒反應,並讓電腦透過機器學習的方式,反覆地學習當個案有什麼樣的問句時,可以由哪些內容進行回應(圖二),所以對話過程會以類似決策樹演算法進行選擇,最後再搭配文字和聲音進行回應,讓個案能夠感受到好像在跟真的心理治療師對話。

圖二 | 心理治療聊天機器人的架構圖(資料來源:作者提供)

圖二 | 心理治療聊天機器人的架構圖(資料來源:作者提供)

AI 融入心理治療後潛在的倫理議題

但是無論是前面提到透過AI 來預測自殺風險、利用聊天機器人幫助個案改善生活困擾或精神症狀干擾,其實都面臨到幾個值得深思的倫理課題。

隱私議題

在預測自殺風險時,個案的資料或是個案與聊天機器人的對話都在電腦或手機進行,這些訊息均會存在商用的雲端檔案中。雲端資料庫雖然有受到妥善的保存,但也可能受到網路的攻擊,或是當事人在對話過程中,忽略要以密碼鎖住資訊,或密碼遭到盜用時,在過程中被不肖人士給侵入或複製; 此外,這些資訊也可能被商業公司作為訓練AI的資料來源,將造成個人隱私洩漏的風險。而傳統的心理治療中,臨床心理師和個案兩個人會在一個隱密的空間進行對話,在個案不與他人傾訴和臨床心理師遵守職業道德的情況下,隱私更顯得安全和保障。……【更多內容請閱讀科學月刊第666期】